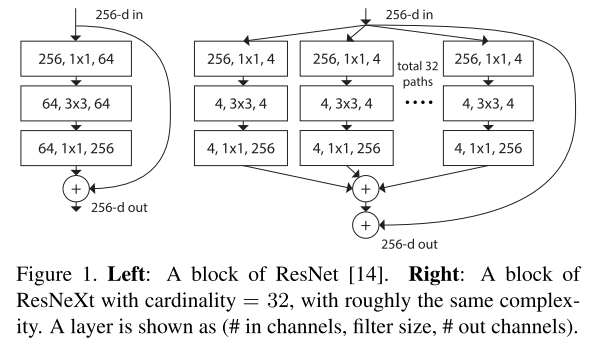

本文提出了深度网络的新维度,除了深度、宽度(Channel数)外,作者将在某一层并行transform的路径数提取为第三维度,称为”cardinality”。跟Inception单元不同的是,这些并行路径均共享同一拓扑结构,而非精心设计的卷积核并联。除了并行相同的路径外,也添加了层与层间的shortcut connection。但由于其多路径的设计特征,我将其归为Inception系网络。

Motivation

深度网络结构上的设计已经有三种经典的范式:

- Repeat. 由AlexNet和VGG等开拓,几乎被之后所有的网络采用。即堆叠相同的拓扑结构,整个网络成为模块化的结构。

- Multi-path. 由Inception系列发扬,将前一层的输入分割到不同的路径上进行变换,最后拼接结果。

- Skip-connection. 最初出现于Highway Network,由ResNet发扬并成为标配。即建立浅层信息与深层信息的传递通道,改变原有的单一线性结构。

Method

文章将残差函数表示为:

其中,C为本层进行的变换数目,即”cardinality”。

相比Inception-ResNet,ResNeXt相当于将其Inception Module的每条路径规范化了,并将规范后的路径数目作为新的超参数。

上图中,路径被扩展为多条,而每条路径的宽度(channel数)也变窄了(64->4)。

NetScope Vis,源文件位于awesome_cnn。

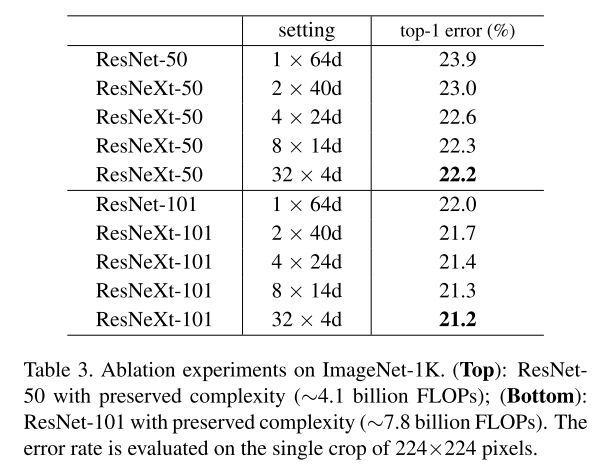

Experiements

ResNeXt试图在保持参数数目的情况下提高网络性能,提升cardinality的同时使每条路径的宽度变窄。

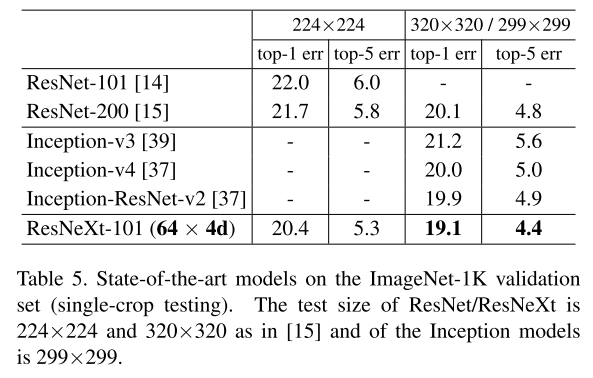

对比其他网络的结果:

Conclusion

ResNeXt较为突出的是把Inception单元规范化了,摆脱了需要精心设计Inception单元中卷积结构的问题,更好地组织了参数。